Höchstleistungsrechenzentrum Stuttgart

Mit dem Gordon Bell Prize werden Simulationen ausgezeichnet, die auf den größten Computern der Welt durchgeführt wurden. Das KAUST-Team nutzte den derzeit weltweit zweitgrößten Supercomputer Fugaku des japanischen RIKEN Center for Computational Science für das nominierte Projekt. Vor dem Zugang zu diesem System mussten die Forscher jedoch zunächst die Wirksamkeit und Skalierbarkeit ihrer Methode nachweisen. Hierfür testeten sie diese auf anderen Supercomputern mit unterschiedlichen Architekturen. Unter anderem liefen die Tests auf dem Supercomputer Hawk des Höchstleistungsrechenzentrums Stuttgart (HLRS), der einer der ersten Supercomputer weltweit mit einer AMD-Hardware ist, die eine beispiellose Cache-Kapazität und -Bandbreite bietet.

„Damit neue Algorithmen von der Forschungsgemeinschaft übernommen werden können, müssen sie auf diverse Höchstleistungsrechnerarchitekturen übertragbar sein. Hawk hat für uns eine wichtige Architektur, auf die wir portieren können“, sagte Dr. David Keyes, Direktor des KAUST Extreme Computing Research Center (ECRC) und leitender Forscher des KAUST-Teams. Neben Hawk testeten sie ihre Methode auch auf dem Shaheen-2-Supercomputer des ECRC und auf Summit im Oak Ridge National Laboratory in den Vereinigten Staaten.

Auf der Suche nach dem Gold der Informatik wollte das Team sicherstellen, dass das Forschungsvorhaben im Sinne der Vision der KAUST ist. Daher haben sich die Forschenden auf die Verbesserung der Leistung globaler Klimamodelle konzentriert.

Seit 2012 setzen Nutzer:innen von Höchstleistungsrechnern (High-Performance-Computing, HPC) zunehmend auf die hohe Rechenkapazität von Grafikprozessoren (GPUs), um die Leistung zu steigern. Die meisten der 20 schnellsten Rechner der im Juni 2022 veröffentlichten Top500-Liste enthielten Grafikprozessoren oder ähnliche Beschleuniger. Wegen der zunehmenden Komplexität der Simulationen stehen Forschende im Hinblick auf den Detailgrad von Großsimulationen wie globaler Klimamodelle weiterhin vor ihren Grenzen.

Mit leistungsfähigeren Computern möchten Klimawissenschaftler:innen so viele Faktoren wie möglich in ihre Simulationen einbeziehen – von der Wolkendecke und historischen meteorologischen Daten bis hin zu Veränderungen im Meereis und Feinstaub in der Atmosphäre. Anstatt diese Elemente von Grund auf zu berechnen – ein Ansatz, der schon heute sehr rechenintensiv wäre – beziehen Forschende diese Informationen mittels statistischer Modelle ein. Die KAUST-Forscher konzentrierten sich speziell auf eine Untergruppe der statistischen Modellierung, die sogenannte „räumliche Statistik“, bei der statistische Daten mit bestimmten geografischen Regionen in einer Simulation verbunden werden. Dieser Ansatz verringert zwar die Belastung durch die Berechnung vieler physikalischer Gleichungen, doch selbst die weltweit führenden Systeme stoßen immer noch an die Grenzen der linearen Algebra – in diesem Fall die Lösung großer, komplexer mathematischer Probleme auf Matrixbasis – die zur Lösung dieser räumlichen statistischen Modelle erforderlich ist.

Kürzlich haben GPUs weitere Chancen für die Bewältigung datenintensiver Anwendungen, u.a. Workflows der künstlichen Intelligenz (KI), eröffnet. Innovative Algorithmen können sowohl leichte Berechnungen sehr schnell lösen als auch GPUs dazu nutzen, große, komplexe Simulationen effizienter als herkömmliche CPUs auszuführen. Sie verringern die Genauigkeit in bestimmten Teilen einer Simulation und führen in anderen Teilen, in denen sie am meisten benötigt werden, rechenintensive Berechnungen durch. In Zusammenarbeit mit Informatiker:innen entwickelte das KAUST-Team Methoden zur Senkung der Rechenkosten dieser großen Simulationen, ohne die Genauigkeit zu beeinträchtigen.

Herkömmliche HPC-Anwendungen führen Berechnungen mit „double precision“ durch, die 64 Bit des Computerspeichers (FP64) beanspruchen. Berechnungen, die zwar immer noch einen wichtigen Beitrag zu einer Simulation leisten können, aber weniger genau sind als FP64, werden als „single-precision“ bezeichnet und benötigen nur 32 Bit Speicherplatz (FP32). Jenseits dieser beiden Pole entwickeln Forschende Berechnungsansätze, die je nach dem für bestimmte Berechnungen innerhalb einer Simulation erforderlichen Detailgrad verschiedene Genauigkeitsstufen verwenden. Diese sogenannten „mixed precision“ Algorithmen können bei richtiger Entwicklung und Implementierung die Vorteile von beiden Seiten für sich nutzen. Sie können sogar mehr als die beiden für HPC typischen Präzisionsstufen unterstützen, bis hin zur „halben Genauigkeit“ oder FP16.

„Mit dem Aufkommen von KI-Anwendungen im Jahr 2012 gab es einen enormen Druck, die GPUs dazu zu bringen, Berechnungen mit geringerer Genauigkeit effektiver zu unterstützen“, sagte Dr. Hatem Ltaief, leitender Forscher am ECRC der KAUST. „Uns wurde klar, dass wir auf diesen Zug aufspringen müssen, bevor er an uns vorbeizieht. Wir fingen an, mit Anwendungsforschenden zusammenzuarbeiten. Dadurch konnten wir zeigen, wie ihre Anwendungen einen gewissen selektiven Genauigkeitsverlust verkraften und trotzdem so laufen können, als ob alles mit 64-Bit-Präzision berechnet worden wäre. Es ist nicht einfach, diese Stellen in komplexen Workflows zu identifizieren und man muss Fachleute miteinbeziehen, damit Entwickler von Algorithmen – wie wir – nicht nur im Dunkeln tappen.“

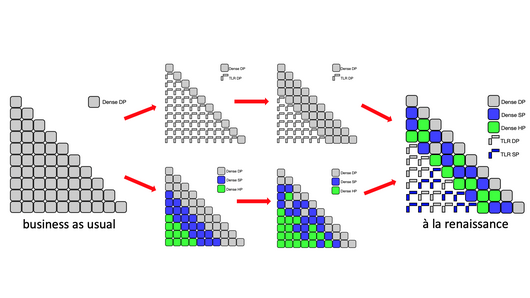

Keyes, Ltaief, Prof. Marc Genton, Dr. Sameh Abdulah und ihr Team an der KAUST begannen mit Forschenden des Innovative Computing Laboratory der University of Tennessee zusammenzuarbeiten. Gemeinsam wollten sie räumliche Statistiken effizient in Klimamodelle einbinden und Kacheln in der Matrix identifizieren, an denen sie die Genauigkeit ihrer Berechnungen während einer Simulation adaptiv erhöhen und senken können. Dafür setzten sie die halbe, einfache oder doppelte Genauigkeit adaptiv ein. Die Forschenden konnten Stellen identifizieren, an denen Berechnungen mit geringerer Genauigkeit noch genaue Ergebnisse liefern. Dies bewahrt sie davor, überflüssige und nichtnotwendige Rechnungen in Simulationen rechnen zu müssen.

Diese Methode stützt sich auf das dynamische Laufzeitsystem PaRSEC, das die Planung von Rechenaufgaben und die bedarfsgerechte Umrechnung von Präzisionsberechnungen steuert. Dies ermöglicht es den Forschern, den Rechenaufwand für die Teile einer Simulation zu verringern, die weniger wichtig oder relevant für das betreffende Ergebnis sind. „Der Kern unserer Entwicklungen ist, dass wir diese anwendungsabhängigen mathematischen Verhaltensweisen nicht im Voraus vorhersehen müssen. Wir können sie sofort erkennen und unsere Einsparungen an das anpassen, was wir in interagierenden Kacheln in Simulationen finden“, so Keyes.

Das Team erzielte eine 12-fache Leistungsverbesserung im Vergleich zu herkömmlichen, modernen dichten Matrixberechnungen. „Wir haben die Herausforderung ganzheitlich betrachtet, die gesamte Matrix in Angriff genommen. Die spärliche Datenstruktur der Matrix haben wir untersucht, wurden fündig und konnten gemischte Präzision verwenden, was eine Lösung für unsere Community und darüber hinaus bietet“, so Ltaief.

Die algorithmischen Innovationen des KAUST-Teams werden Informatikern und HPC-Zentren gleichermaßen zugutekommen. Jedes Jahr werden neue, große Supercomputer gebaut. Damit geht die weltweit steigende Nachfrage nach Strom einher. Wir stehen vor der doppelten Herausforderung, dass CO2-Emissionen reduziert und eine Energieversorgungskrise bewältigt werden müssen. HPC-Zentren suchen weiterhin nach Lösungen, um ihre Energiebilanz zu verbessern. Während sich einige dieser Bemühungen auf die Verbesserung der Hardware-Effizienz konzentrieren – z.B. die Nutzung von Abwärme des Supercomputers oder die Verwendung von wärmerem Wasser zur Kühlung des Systems – versuchen andere sicherzustellen, dass die Simulationen so effizient wie möglich ablaufen und die Datenbewegung auf ein Minimum beschränkt wird.

„Datenströme verursachen einen hohen Energieverbrauch. Die Komprimierung und Verringerung der Gesamtpräzision einer Simulation reduziert gleichzeitig auch das Volumen der Datenverkehr während der Simulation“, so Ltaief. „Wir gehen von einer rechenintensiven Simulation mit großen Datenmengen zu einer speichergebundenen Simulation über, die auf Datenmengen mit einem geringeren Speicherbedarf basiert. Damit verbrauchen wir deutlich weniger Energie.“

Auch das HLRS ist bestrebt, den Energieverbrauch seiner Supercomputer zu reduzieren und wiederzuverwenden. Als Ltaief auf Prof. Dr. Michael Resch, den Direktor des HLRS, zuging, konnte das Team seine Methode auf der Hawk-Architektur testen, während sie sich noch in der Abnahmeprüfung befand.

„Als internationales Forschungszentrum sind wir offen für die Zusammenarbeit mit weltweit führenden Wissenschaftlerinnen und Wissenschaftlern. Wir freuen uns, zu Fortschritt auf unserem Gebiet beizutragen“, sagte Prof. Dr. Michael Resch. „Die Zusammenarbeit mit dem Team der KAUST war ein Vergnügen und eine Ehre.“

Keyes wies darauf hin, dass der Ansatz des Teams vielversprechend ist und auch auf andere Wissenschaftsdisziplinen übertragen werden kann. Diese Dynamik sei einer der schönsten Aspekte der Arbeit als Informatiker. „Mit linearer Algebra können Sie die Welt neu entdecken“, sagte er. Das Team hat seinen Ansatz auf die Signaldekodierung in der drahtlosen Telekommunikation, die adaptive Optik in terrestrischen Teleskopen, die Bildgebung unter der Oberfläche und die Assoziation von Genotyp zu Phänotyp ausgedehnt und plant, ihn in Zukunft auf die Materialwissenschaft zu übertragen.

Eine vollständige Liste aller Nominierten des Gordon Bell Prize 2022 finden Sie hier.

-Eric Gedenk

Hawk wurde vom Ministerium für Wissenschaft, Forschung und Kunst Baden-Württemberg und dem Bundesministerium für Bildung und Forschung über das Gauss Centre for Supercomputing (GCS) finanziert.