Höchstleistungsrechenzentrum Stuttgart

Eines der Instrumente an Bord von Envisat war das Michelson Interferometer for Passive Atmospheric Sounding (MIPAS), mit dem die von der Erdatmosphäre abgegebene Infrarotstrahlung gemessen wurde. Diese Messungen helfen Wissenschaftler:innen dabei, die Rolle der Treibhausgase in unserer Atmosphäre besser zu verstehen.

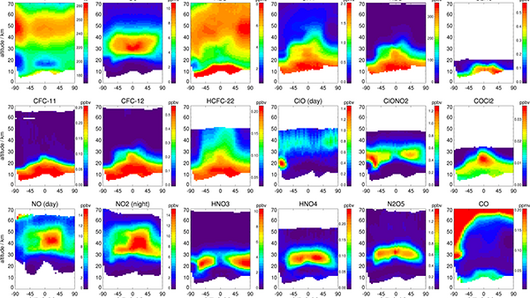

Da viele der in der Atmosphäre vorkommenden Gase in diesen hochauflösenden Spektren charakteristische „Fingerabdrücke“ aufweisen, können Forschende mit jedem Satz von Spektren, die an einem bestimmten Ort aufgenommen wurden, die vertikalen Profile von mehr als 30 wichtigen Gasen erfassen.

Während jeder der 14 täglichen Umkreisungen des Satelliten nahm das Instrument Messungen an bis zu 95 verschiedenen Orten vor, von denen jeder eine Anzahl an 17 bis 35 verschiedenen Spektren aufweist, die Höhen von zwischen fünf und 70 Kilometern, manchmal aber auch bis zu 170 Kilometern entsprechen.

Ein Jahrzehnt komprimierter MIPAS-Spektraldaten füllt insgesamt etwa zehn Terabyte. Um eine so große Datenmenge zeitnah zu analysieren, setzen Forscher:innen des Karlsruher Instituts für Technologie (KIT) und des Instituto de Astrofísica de Andalucía (IAA-CSIC) Höchstleistungsrechner (HPC) ein. Das Team ging eine Partnerschaft mit dem Höchstleistungsrechenzentrum Stuttgart ein, um seinen großen Datensatz sicher speichern und die Supercomputing-Ressourcen des Zentrums zur Modellierung und Analyse der Infrarotspektren von MIPAS nutzen zu können.

„Mit dem Supercomputer des HLRS konnten wir schnell und gründlich einen kompletten Datensatz für unsere zehnjährige Zeitreihe zusammenstellen“, sagt Dr. Michael Kiefer, Forscher am KIT und Leiter des Projekts. „Wir könnten versuchen, diese Arbeit auf Cluster-Computern vorzunehmen, aber wir würden erst nach Jahren ein Ergebnis erhalten, da die Verarbeitung so rechenintensiv ist. Mit HPC können wir unsere Ergebnisse schnell betrachten und eine größere Vielfalt an chemischen Spezies aus den gemessenen Spektren herausarbeiten. Dies ist nicht nur eine quantitative, sondern auch eine qualitative Verbesserung.“

In den vergangenen Jahren hat die wissenschaftliche Datenverarbeitung eine neue Entwicklungsphase erreicht. Jahrzehntelang beruhten die Fortschritte in der Datenverarbeitung auf der Idee des Mooreschen Gesetzes – einer Vorhersage von Gordon Moore, wonach sich die Anzahl der Transistoren auf einem Computerchip aufgrund der schrumpfenden Größe der Transistoren alle zwei Jahre verdoppeln würde. Dies, so vermutete er im Jahr 1965, würde in den kommenden Jahrzehnten zu einem nahezu exponentiellen Anstieg der Rechenleistung führen. Obgleich Moore über Jahrzehnte hinweg Recht behalten sollte, wurde diesem Trend in den vergangenen zehn Jahren ein Ende gesetzt.

Wie es der Zufall wollte, war die reine Rechenleistung allerdings nicht mehr das, was viele Wissenschaftler:innen am dringendsten benötigten. Heute wird die Lösung wissenschaftlicher Fragestellungen häufig nicht mehr von der Verarbeitungsgeschwindigkeit begrenzt, sondern der Notwendigkeit, große Datenmengen effizient zu übertragen, analysieren und speichern.

Dies gilt auch für die MIPAS-Forscher:innen, die ein Jahrzehnt an Daten zu 36 verschiedenen chemischen Spezies und Temperaturen verarbeiten und analysieren müssen. Die komplexe Beziehung von Spurengasen in größeren Höhen erschwert die Arbeit des Teams — die Forschenden müssen das Zusammenspiel von Temperatur, Strahlung, Konzentrationen anderer Chemikalien und Wechselwirkungen untereinander erfassen. Infolgedessen führte das Team rechenaufwändige Berechnungen des nichtlokalen thermodynamischen Gleichgewichts (non-local thermodynamic euqilibrium, NLTE) für diese Spezies durch. Allein die Berechnungen für den Wasserdampf beanspruchten etwa eine Million Kernstunden sowie die Modellierung von neun Spezies mittels NLTE-Methoden.

Obwohl sich diese Simulationen einzeln auf kleineren Anlagen hätten berechnen lassen, würden sie ohne Zugang zu HPC-Ressourcen insgesamt viel zu lange dauern. „Zu Beginn des Projekts arbeiteten wir auf nur einem lokalen Cluster, um einen Monat lang Daten aus der oberen Atmosphäre zu berechnen, für die diese komplexe NLTE-Methode erforderlich ist“, so Dr. Bernd Funke, Forscher am IAA und Mitarbeiter aus dem Projekt. „Um Ergebnisse für einen Monat Daten zu erhalten, brauchte es fast einen Monat an Berechnungen. Jetzt können wir diese Vorgänge in zwei oder drei Nächten durchführen. Aus wissenschaftlicher Sicht ist dieser schnelle Zugriff auf die Daten äußerst wertvoll“.

Sowohl Kiefer als auch Funke wiesen darauf hin, dass die Rechenressourcen des HLRS — sowie die Möglichkeit, die Daten auf dem schnellen und sicheren Höchstleistungsspeichersystem des HLRS zu speichern — dem Team eine schnelle Analyse der Daten ermöglichten.

Nach Beendigung ihrer Analyse des MIPAS-Datensatzes gehen die Wissenschaftler:innen davon aus, dass es in naher Zukunft neue Weltraummissionen im mittleren Infrarotbereich geben wird. In Anbetracht der riesigen Datensätze, die bei diesen Missionen anfallen werden, werden HPC-Zentren wie das HLRS weiterhin eine wichtige Rolle bei der Speicherung, Verarbeitung und Analyse der Daten spielen.

Künftige Missionen wie die kürzlich von der ESA für Vorstudien zur Durchführbarkeit ausgewählte Earth Explorer-Kandidatenmission CAIRT werden bildgebende Verfahren verwenden, die die Anzahl der Messungen pro Umkreisung erhöhen und die Daten um zwei zusätzliche Dimensionen erweitern. Dies wird den Forschenden sowohl einen noch detaillierteren Blick auf die Prozesse in und die Zusammensetzung der Atmosphäre ermöglichen als auch die Komplexität und den Umfang der erforderlichen Datenanalyse erheblich steigern. Die Wissenschaftler:innen schätzen, dass eines der geplanten Instrumente zu einer bis zu tausendfachen Steigerung der erfassten Datenpunkte führen könnte.

Das Team wies auch darauf hin, dass sich das HLRS dem relativ „untraditionellen“ Bedarf an Supercomputing-Ressourcen schnell angenommen hat. Die derzeitige Umstellung in der Wissenschaft auf noch stärker datenzentrierte HPC-Anwendungen unterstreicht die Notwendigkeit für HPC-Zentren, eine Reihe von Tools im Bereich der Datenspeicherung und -verwaltung anzubieten.

Der gesamte MIPAS-Datensatz der chemischen Spezies in der Atmosphäre ist unter folgendem Link verfügbar: https://www.imk-asf.kit.edu/english/308.php

-Eric Gedenk

Finanziert wurde Hawk vom baden-württembergischen Ministerium für Wissenschaft, Forschung und Kunst (MWK) sowie vom Bundesministerium für Bildung und Forschung (BMBF), vermittelt durch das Gauss Centre for Supercomputing (GCS). Hawk ist Teil der nationalen Supercomputing-Infrastruktur des GCS.