Höchstleistungsrechenzentrum Stuttgart

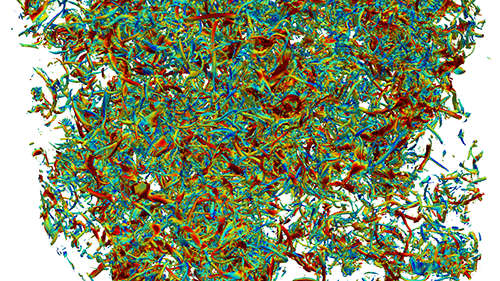

Seit Supercomputer wie der Hawk des HLRS Quadrillionen von Berechnungen pro Sekunde durchzuführen können, können Wissenschaftler Direkte Numerische Simulationen (DNS) erstellen, die Fluidbewegungen ohne vereinfachende Modelle oder Annahmen „von Grund auf“ modellieren. Bei der Berechnung von Turbulenzen in Fluidströmungen ermöglicht DNS Forschern die genaue Simulation kleinster Wirbelbewegungen oder Wirbel, die die großen Bewegungen in einem Fluid beeinflussen.

Dafür braucht man jedoch regelmäßigen Zugang zu großen Supercomputern. Ist dieser nicht möglich, etwa wenn Forscher aus der Industrie die Turbulenz untersuchen wollen, führen sie oft Large-Eddy-Simulationen (LES) durch, die nur das Verhalten der größeren Wirbelbewegungen in einem Fluid berechnen. Dieser Ansatz erfordert auch auf empirischen Daten oder auf anderen Modellen basierende Annahmen über das Verhalten der kleinsten Wirbel. Er braucht zwar weniger Rechenleistung, aber die Forscher wissen, dass selbst kleinste Wirbel stark beeinflussen, wie sich das gesamte System verhält.

Seit kurzem erforschen Forscher um Dr. Andrea Beck am Institut für Aerodynamik und Gasdynamik (IAG) der Universität Stuttgart, wie maschinelles Lernen die Leistungsfähigkeit von DNS auch Forschern mit bescheideneren Computerressourcen zugänglich machen könnte. Als langjährige Nutzerin der HPC-Ressourcen des HLRS für traditionelle Modelle und Simulationen nutzt sie jetzt den Hawk zur Erzeugung von Trainingsdaten für neuronale Netze für bessere LES-Modelle. Ihre Experimente zeigen bereits Potenzial, die Strömungsmechanik-Forschung voranzutreiben.

Der Unterschied zwischen der Modellierung von Turbulenzen mittels DNS und LES ist ähnlich wie bei Fotos. Man kann sich DNS als ein hochauflösendes Foto vorstellen und LES als eine gröbere, pixeligere Version desselben Bildes. Im Gegensatz zu einem Foto haben Forscher jedoch nicht immer Zugang zur hochauflösenden Version eines bestimmten Systems, aus der sie eine genaue Darstellung in geringerer Auflösung entwickeln können. Um diese Lücke in der Flüssigkeitsmodellierung zu schließen, müssen Forscher nach so genannten „Schließungsbedingungen“ suchen.

„Analog zur Fotografie ist die Schließungsbedingung das, was zwischen dem grobkörnigen Bild und dem vollständigen Bild fehlt“, so Beck. „Sie ist die Bedingung, die man im Wesentlichen zu ersetzen versucht. Eine Schließung sagt einem, wie diese Information aus dem Vollbild das grobkörnige Bild beeinflusst.“ Genau wie bei einem bearbeiteten Bild gibt es jedoch viele Möglichkeiten, wie LES-Turbulenzmodelle von DNS abweichen können, und die Wahl der richtigen Schließungsbedingung ist entscheidend für die Genauigkeit von LES.

Das Team begann mit dem Training eines künstlichen neuronalen Netzes, eines maschinellen Lernalgorithmus, der ähnlich wie das menschliche Gehirn neue Informationen verarbeitet und synthetisiert. Bei diesen Methoden werden Algorithmen mit einer Sammlung großer Datensätze trainiert, die oft von HPC-Systemen generiert werden, um Verbindungen herzustellen, die denen ähneln, die im menschlichen Gehirn beim Spracherwerb oder bei der Objekterkennung entstehen. Diese Arten von Algorithmen werden in einer „überwachten“ Umgebung trainiert, also speisen die Forscher große Datenmengen ein, für die sie bereits die Lösung haben; somit ist sichergestellt, dass der Algorithmus immer die richtige Antwort oder Klassifizierung für einen gegebenen Datensatz erhält.

„Beim überwachten Lernen ist es so, als würde man dem Algorithmus 1.000 Bilder von Katzen und 1.000 Bilder von Hunden geben“, so Beck. „Hat der Algorithmus genug Beispiele von jedem gesehen, kann er auf einem neuen Bild unterscheiden, ob eine Katze oder ein Hund darauf ist.“

Für seine Arbeit führte das Team einige DNS-Berechnungen auf den HLRS-Supercomputern durch. Sie führten etwa 40 Läufe mit etwa 20.000 Kernen pro Lauf auf den Supercomputern Hawk und Hazel Hen durch und trainierten dann mit den resultierenden Daten das neuronale Netz. Da dieser Datensatz auch anderen Forschern nutzen könnte, macht ihn das Team 2021 öffentlich zugänglich. Das Team verglich zwei verschiedene Trainingsansätze und stellte fest, dass einer bei korrekter Zuordnung der richtigen Schließungsbedingung zu einer LES-Filterfunktion eine Genauigkeit von 99 % erzielte.

Dank solch vielversprechender Ergebnisse ist das Team zuversichtlich, dass diese datengesteuerten Modellierungsansätze weiter verfeinert werden können, um die Genauigkeit der HPC-gesteuerten DNS-Ergebnisse auf bescheidenere Simulationsansätze zu übertragen. Die Arbeit des Teams ist Beispiel eines neuen Trends in Wissenschaft und Technik: die Verschmelzung und Ergänzung von traditioneller Modellierung und Simulation im HPC mit KI-Anwendungen.

Die neue Erweiterung des Hawk um 192 NVIDIA-Grafikprozessoren unterstützt diese Annäherung und kommt Nutzern zugute, die große Datensätze für das Training neuronaler Netze generieren müssen, da Verzögerungen vermieden werden, die sonst durch das Verschieben von Daten zwischen verschiedenen Rechnersystemen entstehen würden.

„Das ist ein großer Schritt nach vorne, um traditionelle HPC-Codes um neue datengesteuerte Methoden zu ergänzen, und füllt eine deutliche Lücke.“, sagt Beck. „Er wird dazu beitragen, unsere Entwicklungs- und Forschungsprozesse zu beschleunigen. So können wir diese im großen Maßstab auf Hawk einsetzen.“

— Eric Gedenk