Höchstleistungsrechenzentrum Stuttgart

Angesichts der großen KI-Investitionen in den Vereinigten Staaten und China, baut nun auch Europa die KI-Infrastruktur und-Kenntnisse aus, um die Forschungsmöglichkeiten, die Industrieproduktion und die weltweite wirtschaftliche Wettbewerbsfähigkeit zu fördern. Da KI zunehmend den Alltag erobert, versuchen immer mehr Wissenschaftler und Ingenieure ihr Potenzial für ihre Forschungs- und technologische Entwicklungsarbeit aufzudecken. Mittlerweile ist KI aus gängigen Technologien in zahllosen verschiedenen Bereichen wie Landwirtschaft, Finanzwesen, Fertigung und autonomes Fahren nicht mehr wegzudenken.

Um auf den wachsenden Bedarf seiner HPC-Nutzer an Hochschulen und in der Industrie einzugehen, begann das HLRS 2019, sein KI-Potenzial zu erweitern. Das führte auch zur Anschaffung eines neuen Supercomputers, der für KI-Anwendungen optimiert ist, und zur Beteiligung an Projekten, die praktische KI-Anwendungen testen. Zugleich entwickeln Philosophen und Sozialwissenschaftler am HLRS neue Perspektiven für die Beurteilung der Zuverlässigkeit neuer KI-Algorithmen.

Das HLRS ist im Aufbau seiner KI-Kompetenzen, hat aber bereits die Grundlage für eine weitere Annäherung von HPC, High-Performance-Datenanalyse und KI-Ansätzen wie Deep Learning gelegt. Mit dem Blick auf reale Szenarien untersucht das HLRS, wie man diese neuen Methoden und Technologien kombinieren kann, um die Nutzer des Zentrums bestmöglich zu unterstützen und neue Wege zur Bewältigung globaler Herausforderungen zu finden.

Der Wirbel um KI hat so manch einen glauben lassen, dass KI-Anwendungen auf Standardrechnern bald die bereits bewährten Simulationen mit Supercomputern ersetzen könnten. Die am HLRS untersuchten Forschungsmethoden deuten jedoch darauf hin, dass beide Ansätze, ergänzend eingesetzt, auf absehbare Zeit den größten Nutzen bringen werden.

In einfachen Worten: Künstliche Intelligenz ist eine Form der automatischen Erkennung von Mustern. Mit Hilfe künstlicher neuronaler Netze identifizieren und vergleichen Deep-Learning-Anwendungen Unterschiede in großen Mengen an Trainingsdaten und decken Merkmale der relevanten Daten auf. Beim autonomen Fahren könnten dies etwa Bildverarbeitungsalgorithmen zur Erkennung von Fußgängern im Sichtfeld des Fahrzeugs sein. Sobald diese Muster klar definiert sind, nutzen KI-Systeme sie als Entscheidungsgrundlage, beispielsweise um Kollisionen während der Fahrt zu vermeiden.

Die Entwicklung eines Trainingsmodells, mit dem ein KI-Algorithmus „lernen“ kann, erfordert jedoch die Generierung und Verarbeitung einer enormen Datenmenge – eine perfekte Aufgabe für Höchstleistungsrechner. Die Simulation des Sichtfeldes eines Autos bei einer Stadtfahrt etwa erfordert, dass Millionen von Merkmalen gleichzeitig dargestellt werden, und zwar nicht nur einmal, sondern kontinuierlich im Takt von Sekundenbruchteilen. Solche Modelle kann man nur mit Höchstleistungsrechnern entwickeln.

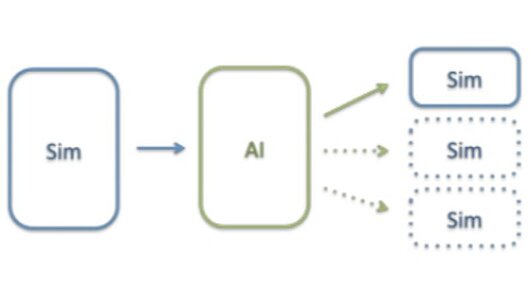

Sobald eine KI-Anwendung große Datensätze durchgearbeitet hat, um ein Vorhersagemodell zu entwickeln, kann man sie in ein vereinfachtes KI-Tool umwandeln, das nicht den gesamten Datensatz erfordert, sondern nur ein Verständnis der Schlüsselparameter beinhaltet. Zum Beispiel können selbstfahrende Autos keinen Supercomputer an Bord haben und man kann nicht auf Cloud-Technologien setzen, um sich durch Kommunikation mit einem Remote-Supercomputer an die sich schnell verändernde Straßenverhältnisse anzupassen. Vielmehr wird das mit HPC abgeleitete Modell in ein anspruchsloseres KI-Tool umgewandelt, das lediglich anhand von Schlüsselmerkmalen in den Daten beobachtet und reagiert.

Ein solcher Ansatz gilt nicht nur für autonomes Fahren, sondern auch für viele Arten von KI-Anwendungen. In der Landwirtschaft etwa könnte KI kombiniert mit neuartigen Sensoren Landwirten helfen, Aussaat und Ernte zeitlich zu optimieren. Im Bauwesen könnten günstige digitale Tools Brücken auf Autobahnen überwachen und auf Sanierungsbedarf hinweisen. Für jede dieser Anwendungen werden Forscher allerdings Supercomputer und Deep Learning benötigen, um die Modelle zu entwickeln, auf denen sie basieren.

Während HPC zur Entwicklung von KI-Anwendungen notwendig ist, beschleunigt auch künstliche Intelligenz die auf traditionellen Simulationsmethoden beruhende Forschung. HLRS-Leiter Dr. Bastian Koller erklärt: „HPC-Systeme werden weiter wachsen, was gut ist, weil wir dadurch größere Probleme angehen können. Problematisch ist jedoch, dass die Datenmengen, die diese größeren Systeme generieren, immer unüberschaubarer werden und es immer schwieriger wird, die nützlichen Daten herauszufiltern. Wir denken, KI könnte ein logischer Weg sein, dieses Problem zu lösen.“

In der numerischen Strömungsmechanik beispielsweise, einem Gebiet, auf dem viele Nutzer der HLRS-Computer spezialisiert sind, haben Wissenschaftler hochpräzise Rechenmodelle komplexer physikalischer Phänomene wie Turbulenzen in Luft- und Wasserströmen entwickelt. Mit den schnellen und leistungsstarken Supercomputern von heute können diese Eigenschaften bei extrem hoher Auflösung mathematisch dargestellt werden. Die Erstellung dieser präzisen Modelle ist jedoch rechenintensiv und damit ungeeignet für bestimmte Probleme bei der Designoptimierung, bei denen es wünschenswert wäre, im Sinne der besten Lösung viele verschiedene Simulationen schnell zu vergleichen.

KI ermöglicht einen anderen Ansatz. Da immer mehr Daten zur Verfügung stehen, testen Wissenschaftler jetzt synthetische Ansätze mit künstlichen neuronalen Netzen. Anstatt ein ganzes System auf der Grundlage physikalischer Prinzipien mühselig zu modellieren, entwickeln Forscher heute mit Deep Learning sogenannte Surrogate Models. Sie nutzen einen datenbasierten Bottom-up-Ansatz, um Modelle zu erstellen, welche die Beziehung zwischen den Eingabe- und den Ausgabedaten simulieren, auf denen das Modell basiert. Diese Surrogate Models ahmen das Verhalten eines traditionellen Simulationsmodells stark nach, und selbst wenn sie nicht so präzise oder aufschlussreich wie traditionelle Simulationen sind, können sie diese Ergebnisse viel schneller annähern. Für einige Probleme bietet dies enorme Vorteile.

In Kollers Augen könnte dieser datengesteuerte Ansatz auch zu neuen Erkenntnissen führen. „Eine der tollen KI-Einsatzmöglichkeiten zur Unterstützung traditioneller Anwendungen des Hoch- und Höchstleistungsrechnens ist die Entdeckung dessen, was ich gerne das unbekannte Unbekannte nenne“, so Koller. „Manchmal gibt es bei großen Datensätzen Abhängigkeiten, die Menschen nicht sehen, weil sie nicht danach suchen. Eine Maschine, die methodisch Daten vergleicht, identifiziert oft Parameter innerhalb von Systemen, die wichtige Auswirkungen haben, die wir nicht erkannt hätten und wiederum neue Möglichkeiten bieten, an die wir nie gedacht hätten."

Dieser Blickwinkel zeigt auf, dass sich KI und HPC in den nächsten Jahren auf einem „Kollisionskurs“ befinden, bei dem neue hybride Ansätze, die beide Bereiche kombinieren, zu neuen Möglichkeiten für die Forschung und die technologische Entwicklung führen werden. HPC wird die großen Datensätze schaffen, die für die Entwicklung zuverlässiger Modelle nötig sind, Deep Learning wird Forschern helfen, diese Daten effizienter zu analysieren, und HPC wird die Ergebnisse nutzen, um zuverlässigere Modelle zu erstellen. Ein iterativer Einsatz dieser beiden Ansätze könnte Forschern also helfen, komplexe Systeme schneller zu verstehen.

Dieses Ziel bringt jedoch technische Herausforderungen mit sich, insbesondere da diese sehr verschiedenen Berechnungsansätze unterschiedliche Hard- und Software erfordern.

Heutzutage bestehen die für Simulation optimierten Supercomputer aus vielen Tausend Central Processing Units (CPUs), einer Art Computerprozessor, der komplexe Berechnungen schnell in Teile zerlegt, diese kleineren Berechnungen schnell parallel über viele CPUs ausführt und sie dann wieder zu einem Ergebnis zusammenfügt. Der HLRS-Supercomputer – ab 2020 ein 26-Petaflop-System namens Hawk – basiert auf diesem Modell, weil es die beste Infrastruktur bietet, um die häufigsten Simulationsprobleme der Nutzer zu lösen.

Der Erfolg von KI-Anwendungen wiederum resultiert aus der Einführung eines anderen Prozessortyps, der sogenannten Graphics Processing Unit (GPU). Ursprünglich für Videospiele entwickelt, sind diese Prozessoren am schnellsten bei iterativen Programmen, bei denen dieselbe Operation wiederholt leicht variiert ausgeführt wird, zum Beispiel bei einem Deep-Learning-Algorithmus unter Einsatz neuronaler Netze. Neben unterschiedlicher Hardware nutzen HPC und KI auch andere Programmiersprachen. Während die Simulation auf großen HPC-Systemen zum Beispiel oft mit Fortran oder C++ erfolgt, werden KI-Anwendungen häufiger in Python oder TensorFlow entwickelt. Die Entwicklung von Workflows, die leicht zwischen verschiedenen Sprachen kommunizieren können, wird auch entscheidend sein.

2016, als das Interesse an Big Data wuchs, begann das HLRS die Möglichkeiten auszuloten, HPC und High-Performance-Datenanalyse besser zu integrieren. Im Zuge eines Gemeinschaftsprojekts namens CATALYST mit Supercomputer-Hersteller Cray Inc. testet das HLRS ein kombiniertes Hardware- und Software-Datenanalysesystem namens Urika-GX auf seine Fähigkeit hin, technische Anwendungen zu unterstützen. Die Forscher untersuchten bereits die Integrationsfähigkeit des Systems mit Hazel Hen, dem Vorgänger von Hawk.

Bis 2019 stieg die Nachfrage der HLRS-Nutzer nach konventionellem Data-Mining und maschinellem Lernen, aber auch nach Deep Learning mit GPUs. Daher kaufte das Zentrum eine neue Supercomputing-Plattform, den Cray CS-Storm. Als GPU-basiertes System, auf dem die KI-Programmier-Suite von Cray installiert ist, ermöglicht das neue System nun dem HLRS, Forschung mit HPC und KI zu unterstützen.

Derzeit verfügt das HLRS über separate spezialisierte Systeme für HPC und Deep Learning, die jeweils eine eigene Architektur, eigene Programmiergerüste und einen eigenen Job-Scheduler haben. „Für die Zukunft“, so Hoppe, „lautet das Ziel, ein integriertes, ganzheitliches System für Ressourcenmanagement und Workflow-Ausführung zu entwickeln, das alles so miteinander verbindet, dass hybride HPC/AI-Workflows auf einer einzigen Plattform ausgeführt werden können."

Während das HLRS seine technische KI-Infrastruktur entwickelt, befassen sich Philosophen und Sozialwissenschaftler in seinem Abteilung Philosophy of Computational Sciences mit ganz anderen Fragen in diesem Bereich: Wann sollte man sich auf Systeme des maschinellen Lernens verlassen, und wie stellen wir sicher, dass KI-Entscheidungen unseren Werten entsprechen?

Deep-Learning-Algorithmen, die zum Beispiel mit neuronalen Netzen Surrogate Models entwickeln, funktionieren wie „Blackboxes“, was es extrem schwierig macht, zu rekonstruieren, wie sie zu ihren Ergebnissen kommen. Obwohl die Ergebnisse in der Praxis oft nützlich sind, stellt dies ein erkenntnistheoretisches Problem für Philosophen dar, das die Frage nach dem tatsächlichen Wissen aufdrängt, das wir haben, wenn wir solche Ergebnisse bekommen. Da KI immer gängiger wird und beispielsweise bei der Bewertung von Kreditrisiken oder der Verurteilung zu Gefängnisstrafen eingesetzt wird, wodurch sie sich direkt auf unser Leben auswirkt, sind diese Grenzen besorgniserregend, insbesondere für Nicht-Wissenschaftler, die von KI betroffen sind, aber nicht verstehen, wie sie funktioniert.

Während einer HLRS-Konferenz im November 2019 ging eine Reihe von Forschern verschiedener Fachgebiete solchen Fragen nach. Da bestehende Ethik-Richtlinien bisher keine große Wirkung hatten, haben sich Mitglieder der HLRS-Philosophieabteilung auch mit dem VDE, der Bertelsmann-Stiftung, dem Institut für Technikfolgenabschätzung und Systemanalyse am Karlsruher Institut für Technologie und dem Internationalen Zentrum für Ethik in den Wissenschaften der Universität Tübingen zusammengetan, um einen systematischeren Rahmen für die Umsetzung von KI-Ethikgrundsätzen in der Praxis zu schaffen. Wie bei den Normungsrahmen für andere Bereiche entwickelt diese Gruppe zur Förderung von Ethik bei KI eine durchsetzbare Reihe von ethischen Richtlinien für Wissenschaftler, Entwickler, Verbraucher und andere, die von KI betroffen sind.

Der Einsatz von KI am HLRS werde sich mit diesem Bereich weiterentwickeln, so Koller. „Mit dem CATALYST-Projekt wollten wir Erfolgsgeschichten schreiben und verstehen, wie wir High-Performance-Datenanalyse und Deep Learning einsetzen müssen. Wir haben viel über die Herausforderungen und Probleme gelernt und sind jetzt einen Schritt weiter gegangen. Wir gehen jetzt nach vorne und decken Lücken auf, die mit KI-Lösungen geschlossen werden könnten. Dabei lernen wir in der Praxis.“

Obwohl die Anwendung von KI-Methoden am HLRS noch in den Kinderschuhen steckt, wird mit Projekten wie HiDALGO ein Rahmen dafür geschaffen, um zu untersuchen, wie KI Wissenschaftlern helfen könnte, die wichtigsten Parameter innerhalb großer Datensätze zu bestimmen. Indem sie Pilotstudien zu Themen wie Prognosen zu Migration und Luftverschmutzung und dem Aufspüren von Fehlinformationen über soziale Medien durchführen, beschränken sich Forscher nicht auf die Theorie dieser Schwierigkeit im Bereich Informatik. Vielmehr arbeiten sie auch direkt an komplexen globalen Herausforderungen, auf die Hoch- und Höchstleistungsrechnen und KI einen Einfluss haben könnten.

Zugleich freut sich das HLRS darauf, seine neue KI-Computerplattform anderen Forschern zur Verfügung zu stellen, die untersuchen möchten, wie diese neuen Ansätze neue Möglichkeiten in ihren eigenen Bereichen bieten könnten.

„Für viele ist KI ein Schweizer Taschenmesser, das alle Probleme lösen wird, aber das stimmt nicht“, erklärt Koller. „Der interessante Part ist nun, herauszufinden, welche Art von Problemen mit KI gelöst werden können und wie HPC dabei hilfreich sein kann. Wir wollen anhand von echten Herausforderungen aus der Realität zeigen, wie man diese neuen Synergieeffekte am besten nutzen kann.“

—Christopher Williams